Numberly crée et héberge des milliers de sites Web et d’API développés par plus d’une centaine de développeurs.

Représentant plus de 4000 projets sur Gitlab, ces interfaces et API deviennent des éléments critiques de l’activité de nos clients une fois en production.

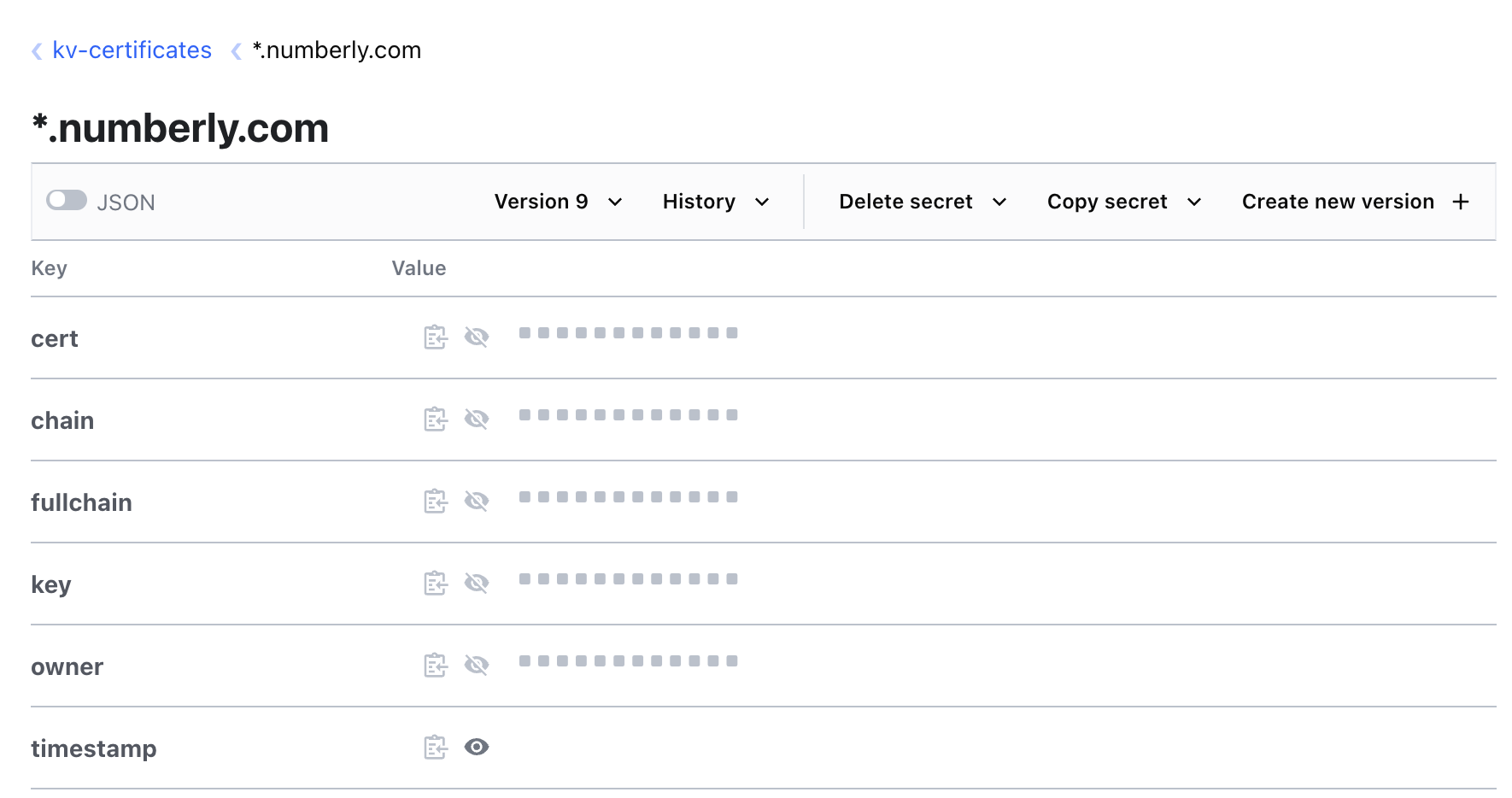

Il est depuis longtemps nécessaire pour nous de protéger l’accès à ces ressources, en commençant par le chiffrement réseau et le HTTPS.

Au fil des ans, nous avons été confrontés à de nombreux défis de mise à l’échelle qui doivent être résolus pour surmonter à la fois la friction que représente la gestion des certificats SSL pour la production mais aussi l’automatisation de leur cycle de vie et de leur maintenance. À bien des égards, nos défis sont similaires à ceux auxquels les hébergeurs à grande échelle tels qu’OVH ont été confrontés.

Il y a un grand fossé entre la gestion d’une douzaine de certificats SSL et la gestion de milliers : on ne peut pas se contenter d’optimiser le temps que les humains passent à les créer/installer/surveiller/renouveler, à un moment donné, vous devez simplement rendre ces opérations transparentes pour que vos développeurs et votre infrastructures puissent grandir sans friction.

Nous avons écrit cette série d’articles pour partager le chemin parcouru depuis 20 ans et notre expérience dans la gestion de ce que l’on pourra regrouper sous le terme de “secrets”. Depuis la gestion des certificats SSL à l’échelle jusqu’à la généralisation de la gestion des secrets aux équipes et aux applications.